用于数据回归的投影支持向量回归算法(外文翻译)

毕业设计(论文)

译文及原稿

译文题目:

用于数据回归的投影支持向量回归算法

原稿题目:

Projection support vector regression algorithms for data

regression

原稿出处:

Science Direct, Knowledge-Based Systems, ELSEVIER. 2016:54

- 66.

用于数据回归的投影支持向量回归算法

彭俊鹏 和 董旭

上海师范大学数学系,上海,200234,中国

摘要

支持向量回归(SVR),已成功应用于各种现实世界问题,同时通过合适的惩罚因子最小化正则化误差和经验风险。然而,它没有将任何先前的数据信息嵌入学习过程。在本文中,通过引入一个新的术语来寻找数据点的投影轴,我们提出一个新的投影SVR(PSVR)算法及其最小二乘版本,即最小二乘法PSVR(LSPSVR)。投影轴不仅最小化投影点的方差,而且使目标和投影输入之间的经验相关系数最大化。轴的发现可以被认为是数据点的结构信息,这使得所提出的算法比SVR更加鲁棒。几个数据集的实验结果也证实了这个结论。在这项工作中的想法不仅有助于理解数据的结构信息,而且可以扩展到其他回归模型。

1.介绍

在过去十年中,由于良好的泛化性能和结构风险最小化(SRM),支持向量机(SVM)[4,5,26,32,33],包括支持向量分类(SVC)[4,5,32,33],支持向量回归(SVR)[26,32,33]和扩展[13,19]已经成为数据分类和回归的有用工具,并已成功应用于各种现实世界的问题[10,17]。

对于经典SVR,其找到对于所有训练点与实际获得的目标 具有至多

具有至多 偏差的函数

偏差的函数 ,并且同时,尽可能平坦。换句话说,它不关心错误,只要它们小于

,并且同时,尽可能平坦。换句话说,它不关心错误,只要它们小于 ,但不会接受大于这个的任何偏差。存在许多学习SVR的算法,例如顺序最小优化(SMO)算法[24]和平滑算法[16]。一些研究者还提出了一系列基于不同损失的新模型函数,如最小二乘SVR(LSSVR)[28,29]和Huber损失基SVR[32,33]。还讨论了一些其他方法,包括正常LSSVR[21],启发式训练[35]和几何方法[3]等。最近,我们在对偶SVM分类器[13]的核心内容中提出了一类新的非平行平面模型用于数据回归,包括对偶SVR(TSVR)[19]和双参数不敏感SVR(TPISVR)模型[20]。这些模型通过一对由两个较小尺寸SVM类型问题求解的非平行上下限函数间接确定回归量,这使得它们不仅在理论上具有更快的学习速度,而且获得与SVR相当的泛化性能。

,但不会接受大于这个的任何偏差。存在许多学习SVR的算法,例如顺序最小优化(SMO)算法[24]和平滑算法[16]。一些研究者还提出了一系列基于不同损失的新模型函数,如最小二乘SVR(LSSVR)[28,29]和Huber损失基SVR[32,33]。还讨论了一些其他方法,包括正常LSSVR[21],启发式训练[35]和几何方法[3]等。最近,我们在对偶SVM分类器[13]的核心内容中提出了一类新的非平行平面模型用于数据回归,包括对偶SVR(TSVR)[19]和双参数不敏感SVR(TPISVR)模型[20]。这些模型通过一对由两个较小尺寸SVM类型问题求解的非平行上下限函数间接确定回归量,这使得它们不仅在理论上具有更快的学习速度,而且获得与SVR相当的泛化性能。

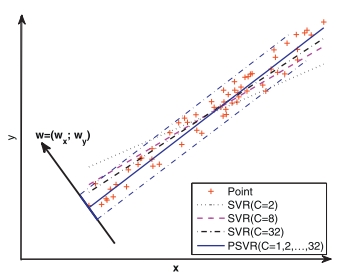

经典SVR的泛化性能明显受参数的影响。图1给出了解释这个问题的线性例子。对于这个例子,它只需要调整给定的 线性SVR(3)中的C值。可以发现,给定小的

线性SVR(3)中的C值。可以发现,给定小的 值,SVR获得差的性能。实际上,如果

值,SVR获得差的性能。实际上,如果 很小,SVR中正则化项的权重,即

很小,SVR中正则化项的权重,即 将变小。然后,我们有一个小的斜率值为这个问题的回归线。为了克服古典SVR中的这种缺陷,一个策略是选择更大的

将变小。然后,我们有一个小的斜率值为这个问题的回归线。为了克服古典SVR中的这种缺陷,一个策略是选择更大的 值,但它可能导致许多现实世界问题的过拟合现象。事实上,如果可以将数据的先前结构信息嵌入到SVR的正则化因子中,使得可以获得法向量方向上的投影点的小方差值,则这个缺点将容易克服。另一方面,数据的先前结构信息有助于改善回归量的性能。

值,但它可能导致许多现实世界问题的过拟合现象。事实上,如果可以将数据的先前结构信息嵌入到SVR的正则化因子中,使得可以获得法向量方向上的投影点的小方差值,则这个缺点将容易克服。另一方面,数据的先前结构信息有助于改善回归量的性能。

图1 PSVR的几何解释

在本文中,我们提出一个新的数据回归SVR模型,称为投影支持向量回归(PSVR)。具体地,该PSVR专用于为训练点生成投影轴,使得投影点具有尽可能小的经验方差值。换句话说,它通过在其目标函数中引入一个新项将数据的先验信息嵌入到学习过程中。因此,它可以克服在经典SVR中的上述缺点。作为经典SVR,它还引入 -不敏感损失函数来描绘训练误差,并且引入

-不敏感损失函数来描绘训练误差,并且引入 范数正则化项以避免可能的过拟合现象,即使函数尽可能平坦。PSVR的优点可以描述如下:

范数正则化项以避免可能的过拟合现象,即使函数尽可能平坦。PSVR的优点可以描述如下: